Image par Natalie Adams

Note de la rédaction : Depuis février 2024, la newsletter mensuelle de NewsGuard – appelée Misinformation Monitor – a laissé place à Reality Check, une newsletter hebdomadaire en anglais, sur les tendances de la mésinformation en ligne. Pour en savoir plus, et vous inscrire sur Substack, c’est par ici.

Les utilisateurs “vérifiés” sur X produisent 74% des affirmations fausses ou sans fondement les plus virales liées à la guerre Israël-Hamas sur la plateforme

Une analyse réalisée par NewsGuard montre que les comptes vérifiés sur X sont des super-propagateurs de mésinformation sur le conflit, en relayant de fausses informations tout en affichant une coche bleue de vérification qui ne vérifie rien du tout.

Par Jack Brewster, Sam Howard, et Becca Schimmel | Publié le 19 octobre 2023

Près des trois-quarts des posts les plus viraux sur X relayant de la mésinformation sur la guerre Israël-Hamas sont promus par des comptes “vérifiés” sur X, comme le montre une analyse de NewsGuard.

En mars 2023, Elon Musk, le propriétaire de X, a modifié le système de vérification de la plateforme, permettant aux utilisateurs de payer 8 dollars par mois pour présenter une “coche” bleue sur leur profil, et ainsi voir leurs posts poussés en priorité par l’algorithme utilisé par X (anciennement Twitter). Cela signifie qu’ils apparaissent en priorité, et avec plus de visibilité, dans les réponses et résultats de recherche des utilisateurs. Cette décision s’est révélée une aubaine pour les acteurs malveillants partageant de la mésinformation sur la guerre entre Israël et le Hamas. Pour un coût inférieur à celui d’un ticket de cinéma, ils bénéficient de la crédibilité associée à la coche bleue, prestigieuse sous l’ancien système, et peuvent atteindre une audience plus large sur la plateforme.

Lors de la première semaine du conflit (7 octobre – 14 octobre), NewsGuard a analysé les 250 posts ayant suscité le plus d’engagement sur X (likes, partages, réponses et signets) relayant l’un de 10 récits faux ou sans fondement parmi les plus populaires en rapport avec la guerre. NewsGuard a extrait ces mythes de sa base de données appelée Empreintes de la Mésinformation, un catalogue des principales infox qui circulent en ligne. Les résultats montrent que 186 des 250 posts – soit 74% – ont été partagés par des comptes vérifiés par X.

Voici les 10 affirmations fausses ou sans fondement partagées par ces comptes vérifiés :

- L’Ukraine a vendu des armes au Hamas

- Israël a tué 33.000 enfants palestiniens depuis 2008

- Une vidéo montre des enfants israéliens ou palestiniens dans des cages

- Une vidéo montre des hauts fonctionnaires israéliens capturés par le Hamas

- L’église orthodoxe Saint Porphyre de Gaza a été détruite par des bombardements israéliens

- Une vidéo montre des combattants du Hamas célébrant l’enlèvement d’un jeune enfant israélien

- CNN a mis en scène des images d’une de ses équipes prise dans une attaque en Israël

- Un mémo de la Maison Blanche montre que les États-Unis ont débloqué 8 milliards de dollars d’aide militaire à Israël

- Israël a mis en scène des images montrant la mort d’un enfant tué par une frappe du Hamas

- L’attaque terroriste du Hamas était une opération “sous faux drapeau” menée par Israël ou l’Occident

Pris ensemble, les posts relayant ces fausses informations ont suscité 1.349.979 engagements et ont été vus plus de 100 millions de fois au total en une semaine seulement.

Quand il est critiqué pour les changements drastiques apportés à la plateforme, et le fait qu’ils ont entraîné une hausse de la mésinformation sur celle-ci, Elon Musk vante souvent les bienfaits de son outil de fact-checking communautaire : les “Notes de la Communauté”. Toutefois, NewsGuard a constaté que seuls 79 posts sur les 250 ayant relayé de la mésinformation sur la guerre présentaient une note de la communauté. Cela signifie qu’une note apparaissait dans environ 32% des cas sur certains des posts les plus nocifs et populaires de la plateforme. (Voir plus d’informations à ce sujet ci-dessous).

NewsGuard a aussi identifié des récits faux ou sans fondement liés à la guerre se propageant largement sur Facebook, Instagram, TikTok, Telegram, et d’autres plateformes. Toutefois, NewsGuard a choisi de se concentrer sur X car cette plateforme est la seule à avoir annoncé la réduction de ses efforts de modération. NewsGuard a aussi constaté que la plupart des faux récits liés à la guerre Israël-Hamas à ce stade sont devenus viraux sur X avant de se propager sur d’autres plateformes comme TikTok et Instagram. En réponse à des questions de NewsGuard envoyées par email au sujet de ces constats et de la vérification des comptes X Premium par la plateforme, l’équipe presse de X a envoyé une réponse automatisée disant en anglais : “Nous sommes occupés, merci de nous faire signe plus tard”.

Les fondements de X Premium

Avant l’acquisition de X (alors Twitter) par Elon Musk, les utilisateurs étaient vérifiés en fonction de leur authenticité, notoriété et activité – dans ce qui est désormais présenté comme “l’ancienne politique de certification” de la plateforme.

Désormais, un utilisateur n’a pas besoin d’avoir une quelconque notoriété pour recevoir une “coche bleue” de vérification. Pour devenir un utilisateur “vérifié” sur X, un utilisateur paie simplement 8 dollars par mois, confirme son numéro de téléphone, et ajoute une photo de profil (X ne précise pas si la photo doit être celle du propriétaire du compte ou d’une personne bien réelle). Le compte doit aussi accepter de ne pas “détourner l’identité de personnes, de groupes ou d’organisations” et de ne pas diffuser du “spam”, selon la page dédiée du Centre d’assistance de X. X indique que la coche bleue apparaît sur le profil d’un utilisateur une fois que “notre équipe aura vérifié que votre compte abonné à X Blue respecte nos critères”.

X ne donne aucune information sur la manière dont il vérifie les demandes de coche bleue, ni même s’il effectue la moindre vérification. Et la plateforme ne requiert pas qu’un vrai nom soit posté sur le compte.

Comme mentionné plus haut, en plus de donner une apparence de crédibilité aux utilisateurs premium, ceux qui possèdent une coche bleue sont aussi promus algorithmiquement par la plateforme. Si les détails précis de la manière dont X promeut et rétrograde (quand la position d’un post est abaissée dans les réponses et résultats de recherche des utilisateurs) ne sont pas révélés et ne sont donc pas clairs, l’analyse de NewsGuard suggère que ce “boost” est significatif, voire crucial, pour qu’un post devienne viral.

En effet, les comptes X Premium ont été au cœur de la propagation des mythes les plus populaires liés à la guerre identifiés par NewsGuard. Si l’on regarde les posts avec le plus d’engagement avançant le mythe le plus partagé que NewsGuard a identifié – selon lequel l’Ukraine aurait vendu des armes au Hamas – 24 posts sur 25 provenaient de comptes X premium. Et 23 des 25 posts relayant le second mythe ayant suscité le plus d’engagement – l’allégation selon laquelle CNN aurait mis en scène une attaque contre une de ses équipes – étaient publiés par des comptes avec la coche bleue de X.

Les super-propagateurs d’infox à coche bleue

NewsGuard a identifié sept comptes ayant relayé au moins deux des mythes les plus populaires sur la guerre. Tous étaient “vérifiés” par X.

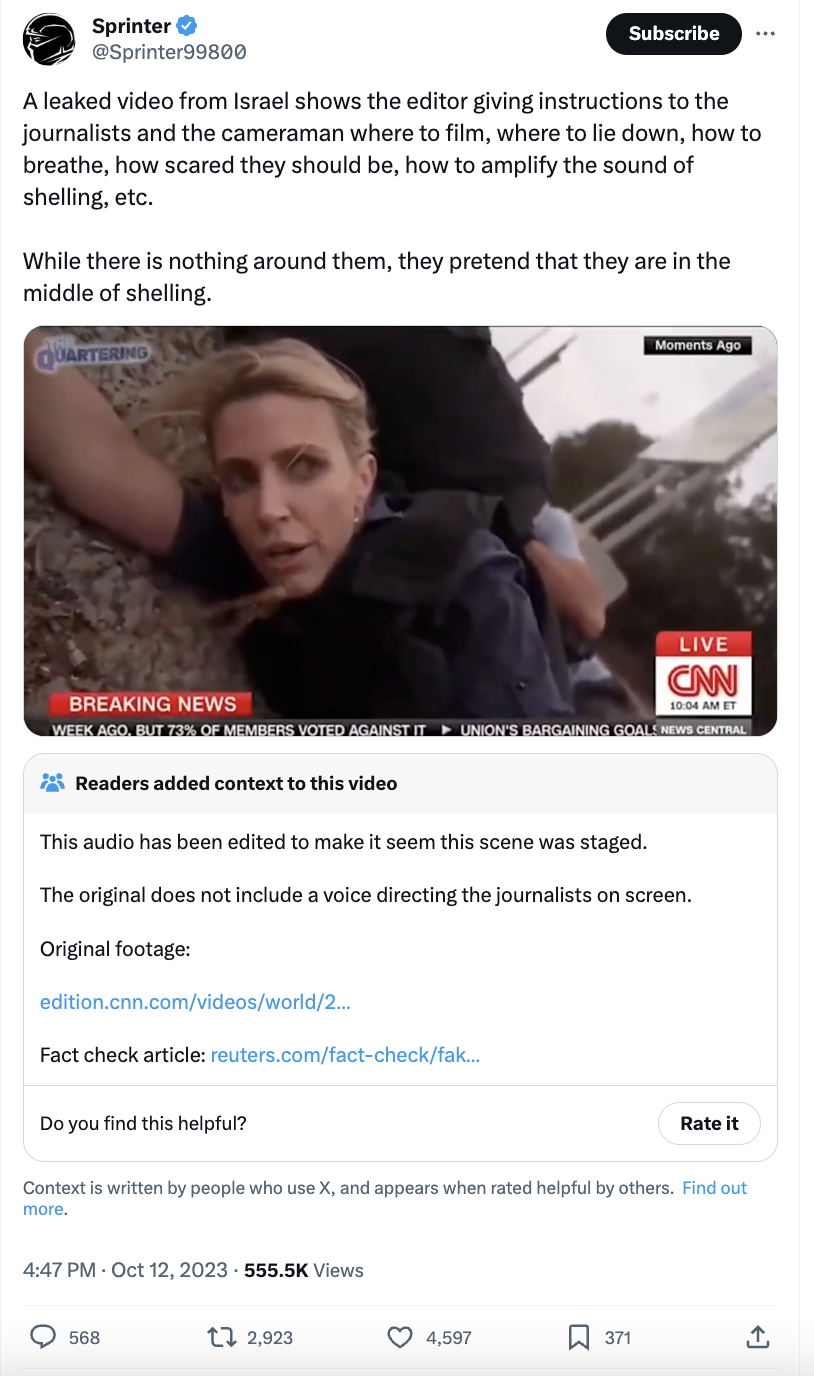

Par exemple, l’utilisateur “vérifié” @Sprinter99800, un compte anonyme avec plus de 361.000 abonnés sur X, a partagé cinq mythes distincts liés à la guerre, dont l’allégation selon laquelle une vidéo sans aucun rapport montrait des hauts fonctionnaires israéliens capturés par le Hamas, et que CNN aurait mis en scène des images d’une attaque contre l’une de ses équipes. Ce compte a été banni de X pour des raisons inconnues en 2022, selon le site de vérification des faits Polygraph.Info, qui est géré par Voice of America, un groupe public américain. Il a toutefois été rétabli par Elon Musk après que ce dernier a acquis X. Il a obtenu la coche bleue de vérification en septembre 2023, un mois avant le début de la guerre entre Israël et le Hamas.

Pris tous ensemble, ces posts de @Sprinter99800 ont été vus près de trois millions de fois au total.

“Une vidéo qui a fuité d’Israël montre l’éditeur (de CNN) donnant des instructions aux journalistes et au cameraman sur où filmer, où se coucher, comment respirer, à quel point avoir l’air d’avoir peur, comment amplifier le bruit d’un bombardement, etc”, a écrit @Sprinter99800, renvoyant vers une vidéo prétendant montrer CNN mettant en scène des images d’une attaque de roquette en Israël. “Alors qu’il n’y a rien autour d’eux, ils prétendent être au milieu d’un bombardement”. (En réalité, une voix-off a été ajoutée à la vidéo pour faire croire que l’équipe était dirigée pour une mise en scène).

Ce post, qui présentait une note de la communauté indiquant (de manière correcte) que l’audio de la vidéo attachée avait été manipulé, avait suscité plus de 8.100 engagements et 550.000 vues au 14 octobre.

Avant la guerre entre Israël et le Hamas, ce compte faisait la promotion d’autres fausses allégations, notamment l’idée qu’un membre du service de sécurité du président ukrainien Volodymyr Zelensky aurait déclenché une bagarre d’ivrognes à New York, et que le ministre ukrainien de la Défense aurait demandé au Canada de mobiliser 30.000 Canadiens pour combattre la Russie.

Un autre utilisateur “vérifié” sur X, Laura Loomer, ancienne journaliste pour Project Veritas (une organisation conservatrice qui filme des vidéos en caméra cachée et critique principalement les démocrates aux États-Unis et les mouvements progressistes), candidate malheureuse au Congrès républicain en Floride en 2020 et 2022, a partagé trois mythes liés à la guerre, dont l’allégation selon laquelle les États-Unis auraient envoyé 8 milliards de dollars d’aide militaire à Israël. Son post du 7 octobre relayant cete infox avait été vu 360.000 fois au 14 octobre.

Le compte vérifié à coche bleue @ShadowofEzra, qui a par le passé relayé des théories du complot proches de QAnon, notamment l’idée que l’Ukraine est un “refuge pour ceux qui ont commis du traffic sexuel d’enfants”, a relayé deux mythes sur la guerre – ainsi que cinq des posts les plus partagés disant que l’attaque contre Israël était une opération sous “faux drapeau”.

Le 11 octobre, @ShadowofEzra a posté le message suivant : “Faux drapeau : le Hamas est la création du gouvernement israélien et ils ont planifié ces attaques et les ont rendues possibles pour obtenir le soutien pour un génocide de masse et probablement mener la troisième guerre mondiale”. Ce post avait été vu 292.000 fois et avait généré 7.350 engagements au 14 octobre. (Une attaque sous “faux drapeau” désigne une attaque faite pour sembler avoir été perpétrée par une autre partie, et non par celle qui a réellement commis l’attaque).

ShadowofEzra a rejoint Twitter en décembre 2022 et, comme @Sprinter99800, il a investi 8 dollars pour devenir un utilisateur X Premium en septembre 2023.

Les notes de la communauté échouent à signaler les infox dans presque 70% des cas

L’une des marques de fabrique de X sous Elon Musk est le recours aux fact-checks produits par la communauté (au travers des notes de la communauté) plutôt que par des fact-checkers professionnels ou d’autres efforts journalistiques indépendants. Toutefois, dans la première semaine de la guerre Israël-Hamas, NewsGuard a constaté que ces fact-checks étaient appliqués de manière inégale aux principaux mythes liés au conflit. En effet, comme indiqué plus haut, ils n’apparaissent pas auprès d’informations fausses dans 68% des cas.

Ces notes de la communauté peuvent fonctionner de manière adéquate – ainsi, de tels fact-checks sont apparus auprès de 21 des 25 principaux posts identifiés par NewsGuard comme relayant la fausse allégation selon laquelle une vidéo montrerait des combattants du Hamas avec un jeune enfant israélien kidnappé.

Toutefois, X n’a attaché une note de la communauté qu’à l’un des 25 principaux posts relayant l’allégation sans fondement selon laquelle Israël aurait tué 33.000 enfants palestiniens depuis 2008, et n’en a attaché qu’à quatre des 25 principaux posts relayant la fausse information selon laquelle un mémo de la Maison Blanche révèlerait que les États-Unis ont envoyé 8 milliards de dollars d’aide militaire à Israël.

Et NewsGuard n’a trouvé qu’une seule note de la communauté (sans aucun lien avec cette infox) sur les 25 principaux posts sur X relayant l’allégation sans fondement selon laquelle l’attaque initiale du Hamas contre Israël était une opération “sous faux drapeau”. L’un de ces posts disait : “ALERTE : De nouveaux rapports indiquent qu’un militaire lié aux services de renseignement de l’armée israélienne a affirmé que l’attaque en Israël était un ‘Faux Drapeau’ pour commencer la ‘Guerre Sainte’ et entraîner la création d’un gouvernement mondial”.

Ce post attribuait cette information à GlobalResearch.ca, un site qui a relayé des théories du complot bien avant la guerre Israël-Hamas, ainsi que de la propagande pro-Russie. Ce site a obtenu un score de confiance NewsGuard de 17,5/100.

Méthodologie

En octobre 2023, NewsGuard a réalisé une analyse des 25 posts avec le plus d’engagement sur X lors de la première semaine de la guerre entre Israël et le Hamas (7 octobre – 14 octobre) pour un total de 10 mythes liés au conflit. Pour ce rapport, NewsGuard a défini l’engagement comme le nombre total de partages, de likes, de signets et de réponses reçues par chaque post. Il est important de noter que les abonnés à X Premium ont l’option de “cacher” la coche bleue signifiant qu’ils sont “vérifiés”. Par conséquent, il est possible que l’analyse par NewsGuard des comptes X Premium sous-estime le total minimum, puisque certains utilisateurs ont peut-être choisi de cacher leur coche bleue.

Note de l’Éditeur: Le 20 octobre 2023, NewsGuard a mis à jour une version précédente de ce rapport qui indiquait que les posts provenant des comptes X Premium étaient promus algorithmiquement dans les “flux” des utilisateurs. NewsGuard entendait par là les posts apparaissant successivement sur toute page de X. Après que NewsGuard a publié ce rapport, X a contacté NewsGuard pour indiquer que les posts provenant des comptes X Premium étaient en réalité promis dans les résultats de recherche et dans les réponses des utilisateurs, mais pas dans les “flux” de page d’accueil des utilisateurs. Par conséquent, NewsGuard a mis à jour ce rapport pour indiquer que les comptes X Premium voyaient leurs posts promus dans les réponses et résultats de recherche.