A cura di McKenzie Sadeghi, Lorenzo Arvanitis, Virginia Padovese, Giulia Pozzi, Sara Badilini, Chiara Vercellone, Macrina Wang, Jack Brewster, Natalie Huet, Sam Howard, Andie Slomka, Leonie Pfaller, Miranda Wollen, e Louise Vallee | Ultimo aggiornamento: 24 ottobre 2025

Dai siti di notizie inaffidabili generati dall’IA che operano con poca o nessuna supervisione umana, fino ad arrivare alle immagini prodotte da software basati su questa tecnologia: la diffusione di strumenti che sfruttano l’intelligenza artificiale generativa ha rappresentato un’autentica manna per le cosiddette ‘content farm’ e per i diffusori di misinformazione.

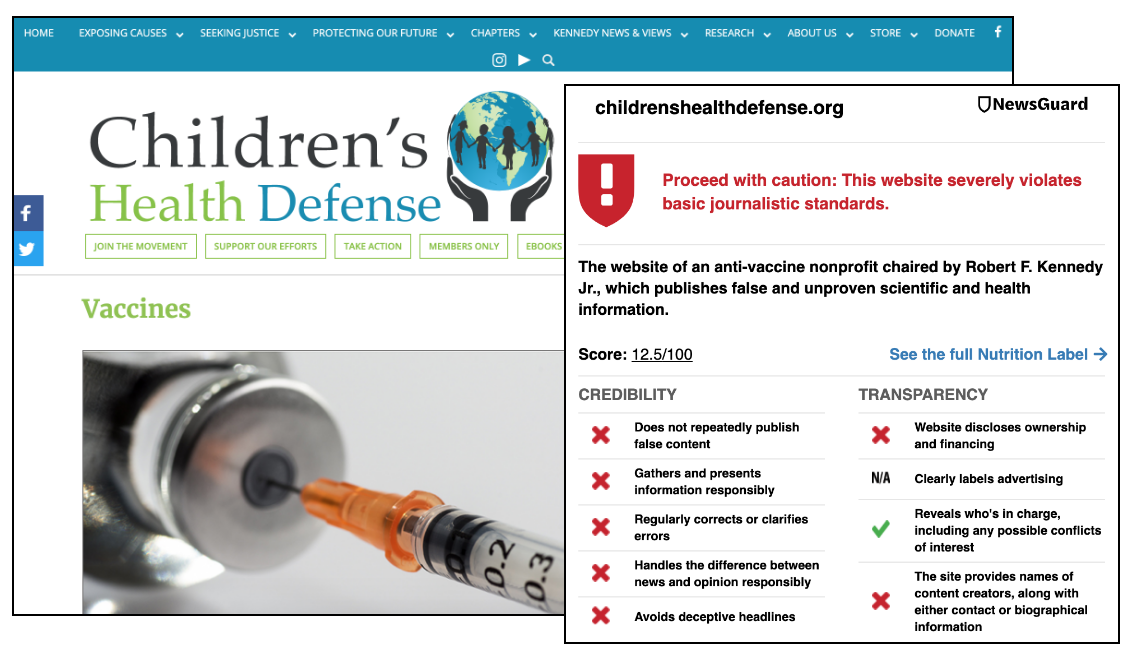

Questo Centro di monitoraggio si propone di evidenziare le modalità con cui l’intelligenza artificiale generativa è stata impiegata per potenziare le operazioni di misinformazione e la diffusione di notizie inaffidabili. Il Centro include inoltre una selezione dei report, delle analisi e dei fact-checking di NewsGuard che riguardano l’intelligenza artificiale.

Ad oggi, il team di NewsGuard ha identificato 2.089 siti di notizie prodotti con IA in modo non trasparente in 16 lingue: arabo, cinese, ceco, coreano, francese, indonesiano, inglese, italiano, olandese, portoghese, russo, spagnolo, tagalog, tedesco, thailandese e turco.

Questi siti hanno solitamente nomi generici – come iBusiness Day, Ireland Top News e Daily Time Update – che agli occhi di un lettore comune potrebbero sembrare quelli di siti di notizie legittimi. Eppure, tali fonti, anziché offrire contenuti giornalistici creati e curati in modo tradizionale, operano con poca o nessuna supervisione umana, e pubblicano articoli scritti in gran parte o interamente da bot. Questi siti hanno sfornato decine e in alcuni casi centinaia di articoli su vari argomenti, tra cui politica, tecnologia, intrattenimento e viaggi. Gli articoli talvolta contengono affermazioni false, come ad esempio bufale sulla morte di personaggi famosi ed eventi inventati o datati, presentati però come se fossero appena accaduti.

In molti casi, il modello di guadagno per questi siti è la pubblicità programmatica, in base alla quale l’industria della tecnologia pubblicitaria fornisce annunci pubblicitari senza tenere conto della natura o della qualità del sito. Di conseguenza, marchi rinomati stanno involontariamente sostenendo questi siti. Finché i brand non prenderanno provvedimenti per escludere le fonti non affidabili dalla lista di quelle autorizzate a pubblicare i loro annunci, le loro pubblicità continueranno a comparire su questo tipo di siti, creando un incentivo economico per il loro sviluppo su ampia scala.

Oltre ai siti inclusi nel Centro di monitoraggio, gli analisti di NewsGuard hanno anche identificato un sito gestito dal governo cinese che cita informazioni generate dall’IA come fonte affidabile per sostenere la falsa teoria secondo cui gli Stati Uniti gestiscono un laboratorio di armi biologiche in Kazakistan. Secondo tale teoria, nel laboratorio verrebbero infettati dei cammelli per danneggiare la popolazione cinese. NewsGuard ha anche identificato una rete di 167 siti di notizie che si spacciano per organi di informazione locali ma hanno legami con la Russia, pubblicano affermazioni false o palesemente fuorvianti sulla guerra in Ucraina e utilizzano prevalentemente l’intelligenza artificiale per generare contenuti.

I ricercatori, le piattaforme, gli inserzionisti, le agenzie governative o altre istituzioni interessate ad accedere all’elenco completo dei domini o a ricevere dettagli sui nostri servizi per le aziende di IA generativa possono contattarci qui. Per avere più informazioni sui dataset di NewsGuard per le piattaforme IA, clicca qui. NewsGuard si occupa delle narrazioni di misinformazione generate dall’IA e di tutte le tendenze su questo tema nei suoi Misinformation Risk Briefing settimanali e nella sua newsletter Reality Check su Substack.