Image via Canva

Note de la rédaction : Depuis février 2024, la newsletter mensuelle de NewsGuard – appelée Misinformation Monitor – a laissé place à Reality Check, une newsletter hebdomadaire en anglais, sur les tendances de la mésinformation en ligne. Pour en savoir plus, et vous inscrire sur Substack, c’est par ici.

L’année où l’IA a démultiplié les infox : 2023 vue par NewsGuard

Par Sara Badilini, Jack Brewster, Eric Effron, Zack Fishman, Sam Howard, Natalie Huet, Chine Labbé, Eva Maitland, Virginia Padovese, Leonie Pfaller, Giulia Pozzi, McKenzie Sadeghi et Roberta Schmid | Publié le 27 decembre 2023

L’essor de l’intelligence artificielle en 2023 a transformé le paysage de la mésinformation, en fournissant aux acteurs malveillants de nouveaux outils pour créer des articles, des images, des sons, des vidéos et même des sites web entiers à l’apparence authentique afin de promouvoir des récits faux ou polarisants destinés à semer la confusion et la méfiance.

NewsGuard a suivi de près la manière dont les outils d’IA sont utilisés pour diffuser toutes sortes de narratifs, allant de la propagande russe, chinoise et iranienne aux informations erronées en matière de santé et aux fausses affirmations au sujet des conflits en Ukraine et à Gaza, épaississant encore un peu plus le brouillard de la guerre. À mesure que ces outils s’améliorent, les faux récits produits par l’IA générative deviennent plus persuasifs et plus dangereux.

Les analystes de NewsGuard ont réalisé des audits des chatbots d’IA générative, tels que ChatGPT d’OpenAI, pour voir comment ils pouvaient être incités (ou manipulés) à générer de fausses allégations, en contournant les garde-fous en place. En août, par exemple, NewsGuard a testé ChatGPT-4 et Google Bard en les encourageant à relayer un échantillon aléatoire de 100 mythes tirés de sa base de données des principaux faux récits circulant en ligne, appelés “Misinformation Fingerprints” (Empreintes de la Mésinformation). ChatGPT-4 a généré 98 mythes sur 100, tandis que Bard en a produit 80 sur 100.

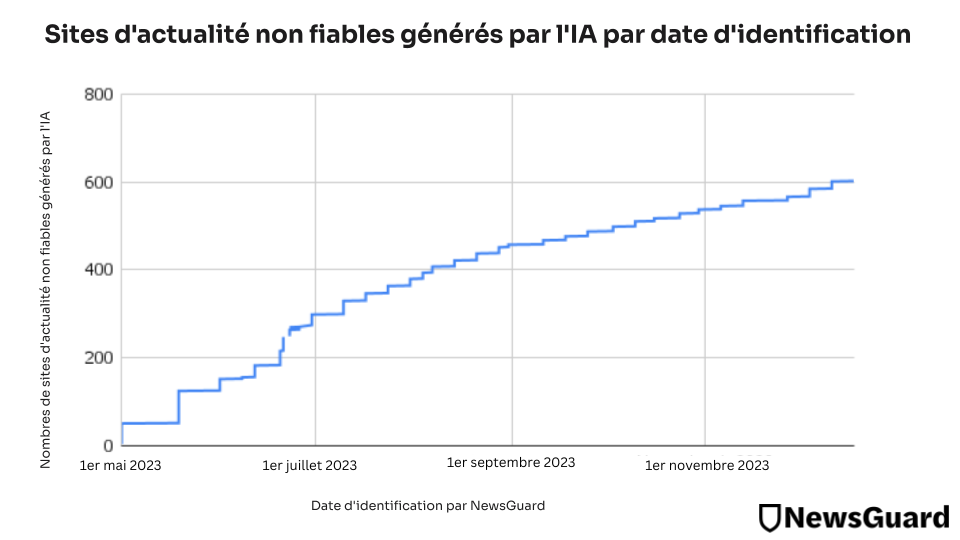

Nous avons également découvert un phénomène croissant par lequel des acteurs mal intentionnés créent des sites web entiers générés par l’IA, qui fonctionnent avec peu voire pas de supervision humaine. À ce jour, l’équipe de NewsGuard a identifié 614 sites d’information non fiables générés par l’IA, surnommés “UAINS” (pour “Unreliable AI-generated News Sites” en anglais), couvrant 15 langues : l’arabe, le chinois, le tchèque, le néerlandais, l’anglais, le français, l’allemand, l’indonésien, l’italien, le coréen, le portugais, l’espagnol, le tagalog (une langue des Philippines), le thaï et le turc (plus d’infos ci-dessous).

Dans ce rapport, nous mettons en avant certaines des utilisations les plus préjudiciables de l’IA, les faux récits les plus partagés de l’année sur les sites évalués par NewsGuard, et un graphique montrant la croissance des sites non fiables générés par l’IA au fil du temps.

Les utilisations les plus “créatives” de l’IA pour générer de fausses informations

Bien utilisés, les outils d’IA peuvent aider les gens à devenir plus productifs, à analyser des ensembles gigantesques de données, et à diagnostiquer des maladies. Cependant, entre de mauvaises mains, les logiciels d’IA peuvent donner un coup d’accélérateur sans précédent à la mésinformation, en fournissant aux acteurs malveillants un contingent illimité de créateurs de contenu, sous la forme de modèles d’IA capables de (et enclins à) produire instantanément des textes, des images, des vidéos et des sons faux ou trompeurs. L’IA a ainsi créé le principal futur “super-propagateur de fausses informations”.

Ci-dessous, nous mettons en lumière certaines des utilisations les plus marquantes de l’IA pour générer des fausses allégations en 2023, sélectionnées par les analystes et éditeurs de NewsGuard.

Obama ? Non. Des outils d’IA audio utilisés pour inonder TikTok de vidéos conspirationnistes

Capture d’écran d’une vidéo TikTok montrant un “Barack Obama” généré par l’IA lisant une fausse “déclaration” sur la mort de Tafari Campbell. (Capture d’écran via NewsGuard)

En septembre, NewsGuard a identifié un réseau de 17 comptes TikTok utilisant un générateur hyperréaliste de voix par l’IA pour amasser des centaines de millions de vues sur des contenus conspirationnistes. Ce réseau, première campagne de mésinformation virale sur TikTok utilisant l’IA dans l’audio selon NewsGuard, semble avoir eu recours à un logiciel de synthèse vocale d’ElevenLabs pour générer instantanément une narration et d’autres voix dans ces vidéos. L’une d’elles, qui relayait l’affirmation sans fondement selon laquelle l’ancien président américain Barack Obama serait impliqué dans la mort de son chef cuisinier personnel Tafari Campbell, montrait un “Obama” généré par l’IA lisant une fausse “déclaration” sur la mort de Tafari Campbell. Lire le rapport de NewsGuard (en anglais) ici.

Un robot plagiaire ? Quand ChatGPT et d’autres chatbots réécrivent de manière trompeuse les contenus de grands médias

En août, NewsGuard a repéré une nouvelle technique par laquelle les sites de piètre qualité utilisent l’IA pour copier le contenu de médias bien connus sans se faire repérer. NewsGuard a identifié 37 sites utilisant des chatbots tels que ChatGPT pour réécrire des articles d’actualité initialement parus dans des médias tels que CNN, le New York Times et Reuters, sans en mentionner la source. Il est difficile de décrire cette nouvelle pratique, et notamment de savoir si les articles réécrits à l’aide de l’IA constituent ou non un “contenu original”. Au mieux, on pourrait parler d’“agrégation efficace”. Au pire, de “plagiat surpuissant”. Lire le rapport de NewsGuard ici.

Citer une réponse de ChatGPT pour relayer une infox concernant… des chameaux

En avril, une vidéo du média étatique chinois China Daily (Score de confiance NewsGuard : 44.5/100) a affirmé, sans aucune preuve, qu’un laboratoire au Kazakhstan prétendument géré par les États-Unis mènerait des recherches secrètes sur la transmission de virus des chameaux aux hommes en vue de nuire à la Chine. La vidéo citait une prétendue confirmation de cette affirmation par ChatGPT. Lire le rapport de NewsGuard (en anglais) ici.

2023 : l’essor des sites d’information non fiables générés par l’IA

En mai 2023, NewsGuard était le premier à identifier l’émergence de ce qu’il appelle les sites d’actualité non fiables générés par l’IA (en anglais Unreliable AI-generated News Sites ou UAINS). Ces sites — qui semblent constituer la nouvelle génération de fermes de contenu — ont plus que décuplé cette année, passant de 49 domaines en mai 2023 à plus de 600 en décembre 2023.

Pour être qualifiés de sites d’actualité non fiables générés par l’IA, les sites doivent remplir les quatre critères suivants :

- Il existe des preuves évidentes qu’une part importante du contenu du site est produite par l’IA.

- Il y a également de fortes raisons de penser que le contenu est publié sans contrôle humain notable.

- Le site est présenté de telle sorte qu’un lecteur moyen pourrait supposer que son contenu est produit par des rédacteurs ou des humains, du fait de sa mise en page, d’un nom générique ou anodin, ou d’autres éléments typiques des sites d’actualité et d’information.

- Le site n’indique pas clairement que son contenu est produit par l’IA.

Les mythes les plus partagés sur les sites évalués par NewsGuard en français, allemand et italien

En 2023, NewsGuard a identifié et démystifié des centaines de nouveaux mythes circulant en ligne. Ci-dessous, NewsGuard a dressé une liste des faux récits les plus répandus cette année sur les sites francophones, germanophones et italophones évalués par NewsGuard dans quatre catégories : la santé, la science, la guerre Russie-Ukraine et la guerre Israël-Hamas. Ces faux récits, apparus en 2023, sont ceux qui ont été relayés à la fois par le plus grand nombre de sites francophones évalués par NewsGuard (y compris des sites français et québécois, entre autres); en allemand (y compris sur des sites basés en Autriche, en Allemagne et en Suisse), et en italien. Chacun de ces mythes est apparu sur au moins 20 sites.

Websites:

Scimex.org (Trust Score: 92.5/100)

An Australian site that is intended to help journalists cover and explain scientific research. Run by the Australian Science Media Centre and the Science Media Centre of New Zealand, it offers boiled-down explanations of research in original articles, a network of experts for journalists to contact, and images that can be used for stories, all for free.

Platformer.news (Trust Score: 92.5/100)

Headed by a veteran Silicon Valley reporter, the site covers the “intersection of tech and democracy” and issues and technology relevant to social media and tech platforms. The site says it will help users understand “the weird new future: internet culture, mega-platform grotesquerie, crypto conspiracies, deep forum lore, fringe politics, and other artifacts of what’s to come.”

RetractionWatch.com (Trust Score: 100/100)

The site serves as a de facto trust police of scientific journals. It is a blog and database dedicated to chronicling retractions of journal articles. Its mission is “tracking retractions as a window into the scientific process.” It’s produced by the Center for Scientific Integrity, a New York City-based 501(c)(3) nonprofit.

DailyYonder.com (Trust Score: 100/100)

Based in a town in rural eastern Kentucky, the site covers economic, political, and cultural issues relevant to rural America. Owned by the nonprofit Center for Rural Strategies, it covers housing crises hitting rural college students, tracks COVID-19 infection rates across statements, and lets users know about the issues affecting rural Americans ahead of the 2024 presidential race.

On3.com (Trust Score: 87.5/100)

The site covers the wickedly competitive recruiting of high school athletes, and new college rules on “Name, Image, Likeness” (NIL) that allow outside payments to athletes. It is similar to two strong competitors, Rivals and 247Sports, with typical headlines “Crash Bandicoot, Activision ink six athletes to NIL deals,” “Koren Johnson, 2022 four-star, commits to Washington,” “Meet Azzi Fudd, the next big thing in women’s basketball — and in NIL.” If you want to know why a quarterback at Duke leaves for Notre Dame, or a University of Michigan basketball star splits for Kansas, the answer is now simple: follow the money.

Podcasts (NewsGuard podcast Trust Scores are out of 10):

Advisory Opinions (Trust Score: 10/10)

A sharp podcast from two conservative lawyers-turned-political and cultural analysts: David French, a New York Times columnist, and Sarah Isgur, a former Justice Department spokesperson during the Trump administration. The hosts assess legal, cultural, and media developments, and are critical of both the left and right. They even heralded the ACLU, a frequent target for the right, for deciding to defend the National Rifle Association in a free-speech case against the New York Department of Financial Regulation.

Drilled (Trust Score: 10/10)

A left-leaning, anti-fossil fuels podcast that offers solid reporting on corporate and political factors that it argues contribute to climate change. It offers multiple viewpoints but tends to rebut critics of climate change, or what it calls “climate accountability.” It’s hosted by environmental journalist Amy Westervelt, who has won honors, including an Edward R. Murrow Award for investigative reporting. A typical episode covers the potential environmental impact of deep-sea mining, which has been performed experimentally on deep ocean floors.

Manifest Space with Morgan Brennan (Trust Score: 10/10)

A weekly podcast in which the CNBC anchor Morgan Brennan covers the latest happenings in space exploration. Brennan discusses significant issues, such as the use of spy satellites and the militarization of space, and interviews industry leaders.