Par McKenzie Sadeghi , Lorenzo Arvanitis , Virginia Padovese , Giulia Pozzi , Sara Badilini , Chiara Vercellone , Macrina Wang , Jack Brewster , Natalie Huet , Sam Howard , Andie Slomka , Leonie Pfaller, Miranda Wollen et Louise Vallee | Dernière mise à jour : 10 février 2025

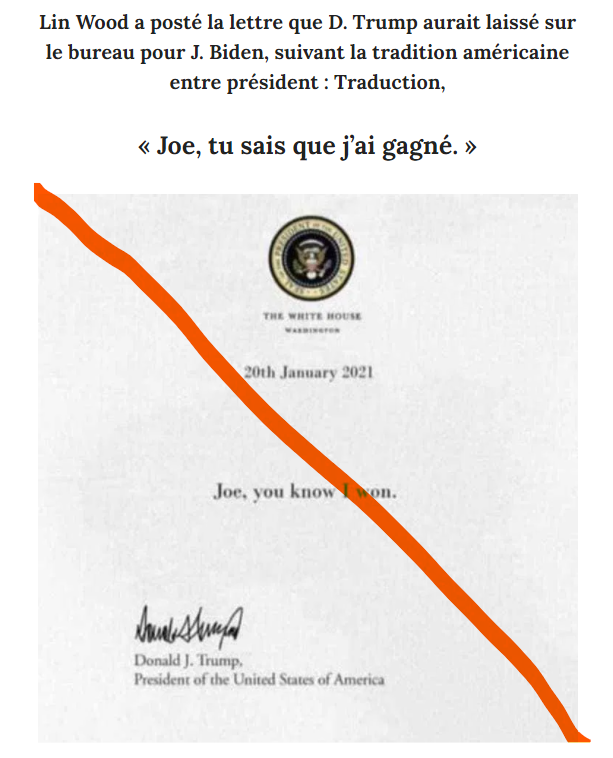

Qu’il s’agisse de médias non fiables générés par l’IA et fonctionnant avec peu ou pas de supervision humaine, ou d’images fabriquées par des générateurs d’images d’IA, le déploiement d’outils d’intelligence artificielle générative a été une aubaine pour les fermes de contenu et les colporteurs de mésinformation.

Ce centre de suivi de l’IA a pour but de mettre en lumière les façons dont l’IA générative a été déployée pour donner un coup d’accélérateur aux opérations de mésinformation et aux actualités non fiables. Le centre présente une sélection de rapports, d’analyses et de fact-checks produits par NewsGuard au sujet de l’intelligence artificielle.

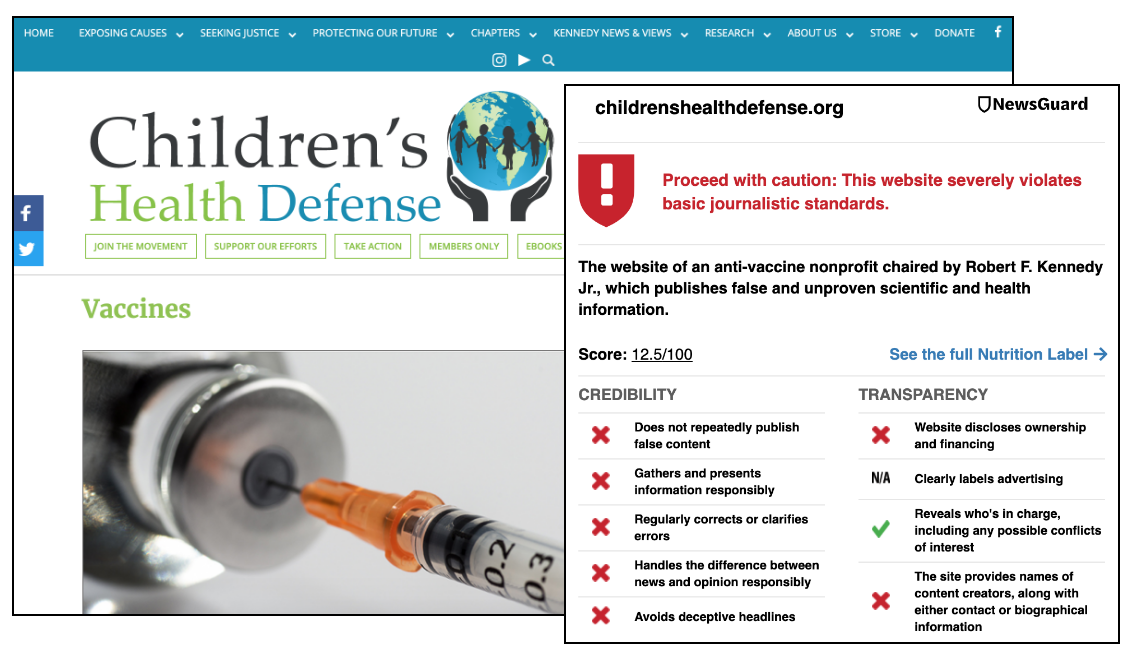

À ce jour, l’équipe de NewsGuard a identifié 1.254 sites d’informations non fiables générées par l’IA, que nous appelons “UAINS” (pour “Unreliable AI-generated News Sites” en anglais), couvrant 16 langues : l’arabe, l’allemand, le chinois, le tchèque, le néerlandais, l’anglais, le français, l’indonésien, l’italien, le portugais, l’espagnol, russe, le tagalog, le coréen, le turc et le thaï.

Ces sites portent généralement des noms génériques, tels que iBusiness Day, Ireland Top News et Daily Time Update, qui ressemblent pour le lecteur à des sites d’actualité classiques. Cela masque le fait qu’ils fonctionnent avec peu ou pas de supervision humaine et publient des articles rédigés en grande partie ou entièrement par des robots – plutôt que de présenter des contenus créés et relus traditionnellement par des journalistes, sous supervision humaine. Ces sites ont produit des dizaines, voire, dans certains cas, des centaines d’articles génériques sur des sujets aussi variés que la politique, la technologie, le divertissement et les voyages. Ces articles contenaient parfois de fausses affirmations, telles que des infox sur la mort de célébrités, des événements fabriqués de toutes pièces et des articles présentant des événements anciens comme s’ils venaient de se produire.

Dans de nombreux cas, le modèle économique de ces sites repose sur la publicité programmatique – des publicités placées de manière algorithmique par les sociétés d’ad-tech sans se soucier de la nature ou de la qualité des sites. Par conséquent, des grandes marques soutiennent ces sites involontairement. Si les marques ne prennent pas de mesures pour exclure ces sites peu fiables, leurs publicités continueront d’apparaître sur ces types de sites, créant un avantage économique à en créer toujours plus, à grande échelle.

En plus des sites inclus dans ce centre de suivi, les analystes de NewsGuard ont identifié un site géré par le gouvernement chinois qui s’appuie sur des textes générés par l’IA comme des sources d’autorité pour diffuser la fausse allégation selon laquelle les États-Unis possèderaient un laboratoire d’armes biologiques au Kazakhstan infectant des chameaux pour mettre en péril la population chinoise. NewsGuard a aussi identifié un réseau de 167 sites d’actualité aux liens avec la Russie se faisant passer pour des sites d’actualité locale publiant des informations fausses ou manifestement trompeuses sur la guerre en Ukraine et utilisant principalement l’IA pour générer des contenus.

Les chercheurs, plateformes, annonceurs, agences gouvernementales et autres institutions intéressées par la liste complète des domaines, ou qui souhaitent recevoir plus de détails sur nos services pour les entreprises d’IA générative peuvent nous contacter ici. Pour en savoir plus sur les bases de données de NewsGuard pour les plateformes d’IA, cliquez ici. NewsGuard suit aussi les récits de mésinformation générés par IA et les tendances liées à l’IA dans ses Briefings hebdomadaires sur la mésinformation, et dans sa newsletter Reality Check, disponible en anglais sur Substack.