McKenzie Sadeghi, Lorenzo Arvanitis, Virginia Padovese, Giulia Pozzi, Sara Badilini, Chiara Vercellone, Macrina Wang, Jack Brewster, Natalie Huet, Becca Schimmel, Zack Fishman, Leonie Pfaller, Miranda Wollen und Natalie Adams | Zuletzt aktualisiert: 24. Oktober 2025

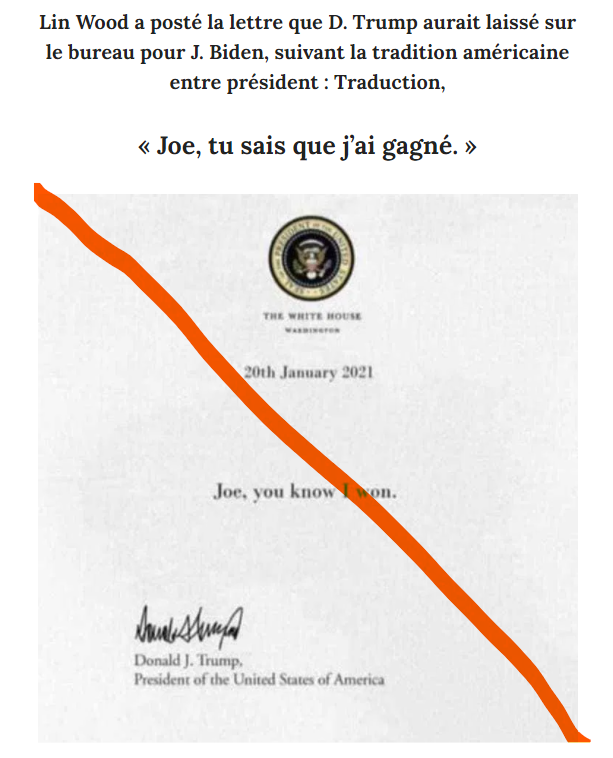

Von Falschnachrichten, die sich wie von selbst und ohne menschliche Kontrolle produzieren lassen, bis hin zu gefälschten Bildern von KI-Bildgeneratoren — die Einführung von generativen Tools der künstlichen Intelligenz ist ein Gewinn für Content-Farmen und Falschinformationsverbreiter gleichermaßen.

Dieses Tracking-Center für Künstliche Intelligenz soll aufzeigen, wie generative KI eingesetzt wird, um die Verbreitung von Fehlinformationen und unzuverlässigen Nachrichten zu verstärken. Dazu liefert das Tracing-Center eine Auswahl an NewsGuards Analysen, Berichten und Faktenchecks zum Thema künstliche Intelligenz.

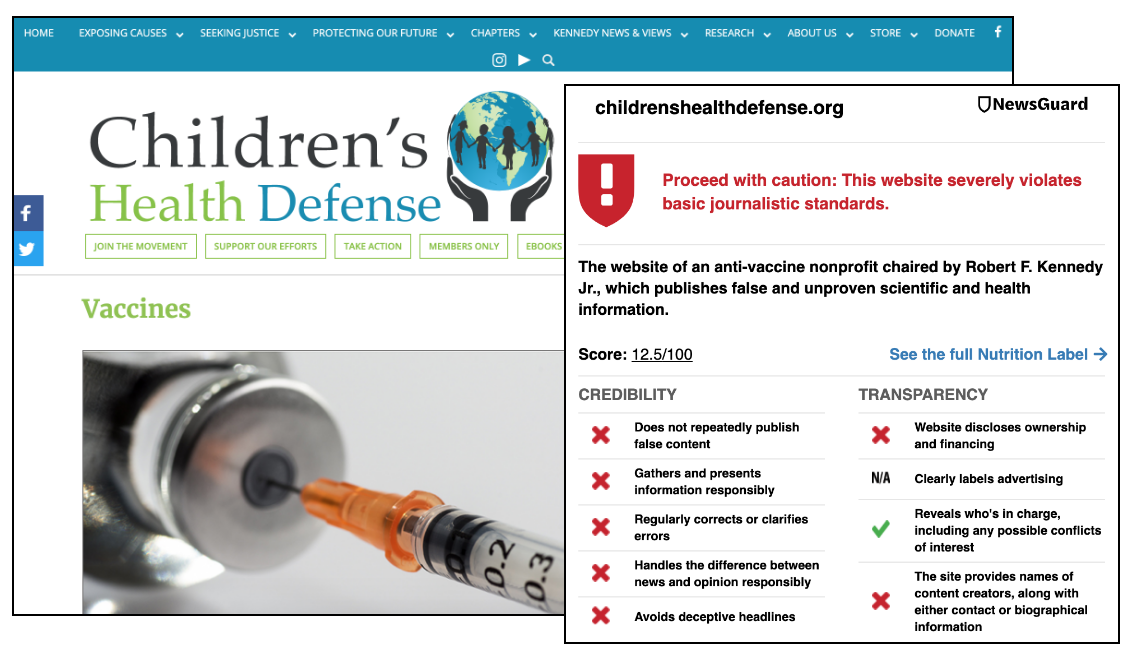

Bis jetzt hat das Team von NewsGuard mehr als 2000 solcher Webseiten in 16 Sprachen aufgedeckt: Arabisch, Chinesisch, Tschechisch, Niederländisch, Englisch, Französisch, Deutsch, Indonesisch, Italienisch, Koreanisch, Portugiesisch, Russisch, Spanisch, Tagalog, Thai, und Türkisch.

Diese Webseiten tragen in der Regel generische Namen wie z. B. iBusiness Day, Ireland Top News und Daily Time Update. Für Online-Nutzer:innen sehen sie aus wie etablierte Nachrichtenseiten und täuschen darüber hinweg, dass sie ohne menschliche Kontrolle arbeiten und die Artikel größtenteils oder vollständig von Bots verfasst werden. Die Webseiten haben zahlreiche und in einigen Fällen Hunderte von allgemeinen Artikeln zu einer Reihe von Themen wie Politik, Technologie, Unterhaltung und Reisen veröffentlicht. Mitunter enthalten sie jedoch falsche Behauptungen, wie etwa über den angeblichen Tod von Prominenten:innen, andere erfundene Ereignisse oder zeitlich verzerrte Darstellungen von Geschehnissen.

In vielen Fällen handelt es sich bei dem Ertragsmodell der Webseiten um programmatische Werbung, bei der die Ad-Tech-Industrie Anzeigen ohne Rücksicht auf die Art oder Qualität der Webseite schaltet. Infolgedessen unterstützen führende Marken unbeabsichtigt diese Webseiten. Solange Marken keine Maßnahmen ergreifen, um nicht vertrauenswürdige Webseiten zu vermeiden, werden ihre Anzeigen weiterhin auf solchen Webseiten erscheinen und so einen wirtschaftlichen Anreiz für deren Erstellung schaffen.

Zusätzlich zu den in den Tracker aufgenommenen Webseiten haben die Analyst:innen von NewsGuard auch eine von der chinesischen Regierung betriebene Webseite identifiziert, die KI-generierte Texte als Quelle für die falsche Behauptung verwendet, die USA betrieben ein Biowaffenlabor in Kasachstan, in dem Kamele infiziert würden, um Menschen in China zu gefährden. NewsGuard hat außerdem ein Netzwerk von 167 Nachrichten-Websites mit Verbindungen zu Russland identifiziert, die sich als Lokalmedien ausgeben, falsche oder irreführende Behauptungen über den Ukraine-Krieg veröffentlichen und in erster Linie KI zur Generierung von Inhalten nutzen.

Forschende, Plattformen, Werbetreibende, Regierungsbehörden oder andere Institutionen, die an der vollständigen Liste der Webseiten interessiert sind oder mehr über unsere Dienstleistungen für generative KI-Unternehmen erfahren möchten, können uns hier kontaktieren. Um mehr über die transparenten Datensätze von NewsGuard für KI-Plattformen zu erfahren, klicken Sie hier. NewsGuard berichtet außerdem über KI-generierte Falschinformationen und Trends in seinen wöchentlichen Misinformation Risk Briefings sowie im Reality Check Newsletter auf Substack.